X

X o non è un elemento di X,

o non appartiene ad X,

X non contiene o,

o non è contenuto in X

Appunti di Algebra e Geometria

Ettore Forigo

P ∧ Q: P e Q

P ∨ Q: P o Q

∀v ∈ D.P(v): Per ogni v in D vale P(v)

∃v ∈ D : P(v): Esiste almeno un v in D tale che P(v)

∃!v ∈ D : P(v): Esiste un unico v in D tale che P(v)

Un insieme (set) è una collezione di oggetti non ordinata e senza molteplicità

(senza ripetizioni).

Dato un insieme X, per ogni oggetto o:

o ∈ X

o è un elemento di X,

o appartiene ad X,

X contiene o,

o è contenuto in X

∨

o X

X

o non è un elemento di X,

o non appartiene ad X,

X non contiene o,

o non è contenuto in X

Un insieme può essere definito:

- per elencazione: scrivendo gli elementi tra parentesi graffe, separati da

virgole.

e.g.

{a,b,c}

- per proprietà caratteristica o per comprensione (set comprehension /

set-builder notation): indicando una proprietà P che caratterizza gli elementi

dell’insieme X

∀o ∈ Y.o ∈ X ⊆ Y ⇐⇒ P(o)

con le scritture:

X = {o ∈ Y |P(o)}

X = {o ∈ Y : P(o)}

X = {o|o ∈ Y ∧ P(o)}

X = {o : o ∈ Y ∧ P(o)}

X = {o|o ∈ Y,P(o)}

X = {o : o ∈ Y,P(o)}

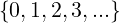

ℕ = Numeri Naturali =

ℤ = Numeri Interi

ℚ = Numeri Razionali

ℝ = Numeri Reali

ℂ = Numeri Complessi  ℝ × ℝ = ℝ2

ℝ × ℝ = ℝ2

ℕ0 = ℕ ∖

ℚx = ℚ∗ = ℚ ∖

ℝx = ℝ∗ = ℝ ∖

ℂx = ℂ∗ = ℂ ∖

La cardinalità (cardinality)  = n ∈ ℕ di un insieme A è il numero di

elementi in A.

= n ∈ ℕ di un insieme A è il numero di

elementi in A.

Un insieme X si dice sottoinsieme (subset) di un insieme Y, scritto X ⊆ Y , se

ogni elemento di X è anche un elemento di Y .

X ⊆ Y ⇐⇒∀e ∈ X.e ∈ Y

Un insieme X si dice sottoinsieme proprio (proper subset) di un insieme Y,

scritto X ⊂ Y , se X è diverso da Y e ogni elemento di X è anche un elemento di

Y .

X ⊂ Y ⇐⇒ X≠Y ∧∀e ∈ X.e ∈ Y

L’unione (union) A ∪ B di due insiemi A e B è l’insieme contenente sia gli

elementi di A che di B.

A ∪ B = {e : e ∈ A ∨ e ∈ B}.

L’intersezione (intersection) A ∩ B di due insiemi A e B è l’insieme

contentente gli elementi che sono sia elementi di A che elementi di B.

A ∩ B = {e : e ∈ A ∧ e ∈ B}.

La differenza (difference) A − B o A ∖ B di due insiemi A e B è l’insieme

contentente solo gli elementi di A che non sono elementi di B.

A − B = A ∖ B = {e : e ∈ A ∨ e B}.

B}.

Un multiinsieme (multiset) o sistema è una collezione non ordinata di elementi

con molteplicità (ovvero un insieme con ripetizioni).

e.g.

[a,b,c]

Una sequenza (o ennupla / n-upla) è una collezione ordinata di elementi.

(a,b,c)

Diciture per numeri di elementi:

2 - Paio (pair), coppia (couple) o tupla (tuple)

3 - Terna (triplet) o tripla (triple)

4 - Quaterna (quatern) o quadrupla (quadruple)

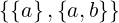

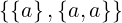

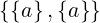

(a,b) : =

(a,a) =  =

=  =

=

(a,b,...,y,z) = (a,(...,(y,z))) oppure (((a,b),...),z)

Alternativamente:

Sequenza di k elementi di A: Ak = A × (A × (... × A))

k volte

Alternativamente:

In = i ∈ ℕ : 0 < i ≤ n

Sequenza di n elementi di A = a : In → A (funzione di accesso)

Il prodotto cartesiano (cartesian product) A × B di due insiemi A e B è

l’insieme contenente tutte le coppie di due elementi dove il primo elemento

appartiene ad A ed il secondo elemento appartiene a B.

A × B = {(a,b) : a ∈ A,b ∈ B}.

Si dice che R ⊆ A × B è una relazione (binaria, anche detta corrispondenza)

((binary) relation) tra due insiemi A e B.

Se:

C : =

Si scrive:

b1 = C(a1)

b2 = C(a2)

O anche:

a1Cb1 a2Cb2

Una relazione R tra A e B si dice ovunque definita (o totale a sinistra, duale

della totalità a destra (suriettività)) se associa ad ogni elemento di A almeno un

elemento di B.

In simboli:

∀x ∈ A.∃y ∈ B : (x,y) ∈ R

Una relazione R tra A e B si dice funzionale (o univalente / unica a destra,

duale dell’iniettività) se ogni elemento di A in R è associato ad un solo elemento

di B.

In simboli:

∀x ∈ A,y,z ∈ B.xRy ∧ xRz  y = z

y = z

Oppure:

∀x ∈ A.(∃y ∈ B : (x,y) ∈ R  ∃!y ∈ B : (x,y) ∈ R)

∃!y ∈ B : (x,y) ∈ R)

Una relazione f si dice funzione se è funzionale e ovunque definita.

“Funzione” si riferisce alla terna: associazione di elementi, dominio e codominio,

non solo all’associazione di elementi. Specificare solo un’associazione non

definisce una funzione: occorre specificare anche dominio e codominio. Infatti,

due funzioni che hanno una “stessa” associazione di elementi ma diverso dominio

e/o diverso codominio sono funzioni diverse.

Si scrive:

f : A → B

dove A è il dominio di f e B è il codominio di f.

Una funzione f si dice iniettiva (injective) (unica a sinistra, duale della

funzionalità) se associa a due qualsiasi elementi distinti del dominio elementi

distinti del codominio.

In simboli:

∀x,x′∈ dom(f).f(x) = f(x′)  x = x′

x = x′

Una funzione f si dice suriettiva (surjective) (o totale a destra, duale della

totalità a sinistra) se per ogni elemento del codominio associa almeno un

elemento del dominio ad esso.

In simboli:

∀y ∈ codom(f).∃x ∈ dom(f) : y = f(x)

(equivalentemente: im(f) = codom(f))

Una funzione f si dice biiettiva (bijective) (o biiezione, o anche corrispondenza

1 a 1 o biunivoca) se è sia iniettiva che suriettiva, cioè ad ogni elemento del

dominio corrisponde uno ed un solo elemento del codominio.

In simboli:

∀x,x′∈ dom(f).x≠x′ f(x)≠f(x′)

f(x)≠f(x′)

∀y ∈ codom(f).∃x ∈ dom(f) : y = f(x)

Osservazione:

f : A → B è biiettiva

=

=

A e B possono essere infiniti.

<

<  ⇐⇒∃ una funzione iniettiva X → Y ∧ ∄ una biiezione X → Y .

⇐⇒∃ una funzione iniettiva X → Y ∧ ∄ una biiezione X → Y .

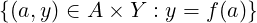

L’insieme di tutti i valori di f : A → B valutata in ogni elemento di S ⊆ A si dice

l’immagine di S tramite f:

f[S] = f(S) : =  ⊆ B

⊆ B

Imf = im(f) = f[A]

L’immagine del dominio di una funzione f tramite f si dice immagine di

f.

im(f) ⊆ codom(f)

Il valore di f : A → B valutata in x ∈ A si dice immagine di x tramite f.

L’insieme degli elementi del dominio di una funzione f : A → B che f associa a

tutti gli elementi di S ⊆ B si dice controimmagine, preimmagine o immagine

inversa di S tramite f:

f−1[S] = f−1(S) : =  ⊆ A

⊆ A

La controimmagine di un singolo elemento e ∈ S tramite f è definita come f−1[e].

Detta anche restrizione del dominio o restrizione a sinistra.

f : A → B,X ⊆ A

Si dice restrizione di f ad X la funzione:

fX : X → B

fX(x) : = f(x) ∀x ∈ X

O equivalentemente:

fX : X → B : =

O ancora:

fX : X → B : = f ∘ i

Dove i : X → A è l’inclusione di X in A data da i(a) : = a.

Una notazione equivalente è:

f|X = fX

Detta anche corestrizione, restrizione del codominio o restrizione a destra.

f : A → B, Im(f) ⊆ Y

Si dice troncatura di f ad Y la funzione:

fY : A → Y : =

Osservazione:

Il codominio viene ristretto.

Una notazione equivalente è:

f|Y = fY

In generale prima si restringe e poi si tronca una funzione.

f : A → B, g : B → C

L’elemento b che compone in (g ∘ f) è unico ∀a ∈ A.

f : A → B ammette inversa destra g : B → A | (f ∘ g) : B → B, ∀x ∈ B.(f ∘ g)(x) = x ⇐⇒ f è suriettiva.

f : A → B ammette inversa sinistra g : B → A | (g ∘ f) : A → A, ∀x ∈ A.(g ∘ f)(x) = x ⇐⇒ f è iniettiva.

f : A → B ammette inversa destra e sinistra  f ammette inversa f−1 che

coincide con l’inversa destra e sinistra.

f ammette inversa f−1 che

coincide con l’inversa destra e sinistra.

f ammette inversa ⇐⇒ f è biettiva.

Una funzione f si dice successione se:

f : ℕ → A

Si dice operazione binaria (binary operation) una funzione o : A × B → C

Si dice operazione binaria interna (o chiusa) (internal/closed binary operation) su di un insieme U una funzione o : U × U → U

Si dice operazione binaria esterna (external binary operation) una operazione binaria o : B × A → A

Una struttura algebrica (algebraic structure) consiste in un insieme, una

collezione (non vuota) di operazioni su di esso e un insieme finito di

identità o proprietà, dette assiomi, che le operazioni devono soddisfare.

Si rappresenta con una ennupla contenente l’insieme e le operazioni:

(U,o)

Un magma o gruppoide (grupoid) (struttura algebrica) (A,∗) è un insieme

dotato di un’operazione binaria interna.

∗ : A × A → A

(a,b) = a ∗ b

Se (A,∗) è un magma, si dice che e ∈ A è un elemento neutro (identity

element) per ∗ se è sia elemento neutro destro che elemento neutro sinistro per ∗,

ovvero se operando e sia a destra che a sinistra con qualsiasi elemento di A si

ottiene di nuovo il medesimo elemento.

In simboli:

∀a ∈ A.e ∗ a = a ∗ e = a

Se ∗è una operazione binaria A × B → A, si dice che e ∈ B è un elemento

neutro destro per ∗ se:

∀a ∈ A.a ∗ e = a

Se ∗è una operazione binaria esterna B × A → A, si dice che e ∈ B è un

elemento neutro sinistro per ∗ se:

∀a ∈ A.e ∗ a = a

Un magma (A,∗) è un magma unitario (unital magma) (struttura algebrica) se ∗ ammette elemento neutro.

Se (A,∗) è un magma si dice che ∗è associativa se, quando l’operazione è

usata in notazione infissa, spostando le parentesi (cambiando l’ordine di

svolgimento delle operazioni, n.b. non l’ordine degli operandi) il risultato non

cambia. Questo significa che le parentesi si possono aggiungere, rimuovere o

spostare senza cambiare il significato dell’espressione e senza ambiguità.

In simboli:

∀a,b,c ∈ A.a ∗ (b ∗ c) = (a ∗ b) ∗ c

Un magma (A,∗) è detto semigruppo (semigroup) (struttura algebrica) se ∗è associativa.

Un semigruppo (A,∗) è detto monoide (monoid) (struttura algebrica) se ∗ ammette elemento neutro.

Sia (A,∗) un magma unitario con elemento neutro e.

Si dice che ∀a ∈ A:

a′è inverso destro di a se ∃x′∈ A : a ∗ a′ = e

a′′è inverso sinistro di a se ∃x′′∈ A : a′′∗ a = e

a′′′è inverso di a se a′′′è inverso destro di a ∧ a′′′è inverso sinistro

a.

Un monoide (A,∗) è detto gruppo (group) (struttura algebrica) se ogni elemento di A ammette inverso (destro e sinistro, necessariamente unico, solitamente indicato con a−1).

Un sottoinsieme di un gruppo è un sottogruppo se è a sua volta un gruppo con

la stessa operazione.

In generale un sottoinsieme di un insieme con una struttura algebrica è sua sottostruttura se anch’esso ha la medesima struttura algebrica.

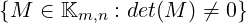

GLn(𝕂) : =  , chiamato gruppo lineare generale (general

linear group) (o gruppo di matrici), è un gruppo rispetto al prodotto di matrici

(righe per colonne). L’insieme può essere definito equivalentemente come

l’insieme delle matrici invertibili. Più in generale è il gruppo formato

dall’insieme degli automorfismi (sia isomorfismi che endomorfismi, endomorfismi

invertibili o isomorfismi da un oggetto a se stesso) di un oggetto matematico.

, chiamato gruppo lineare generale (general

linear group) (o gruppo di matrici), è un gruppo rispetto al prodotto di matrici

(righe per colonne). L’insieme può essere definito equivalentemente come

l’insieme delle matrici invertibili. Più in generale è il gruppo formato

dall’insieme degli automorfismi (sia isomorfismi che endomorfismi, endomorfismi

invertibili o isomorfismi da un oggetto a se stesso) di un oggetto matematico.

Esiste anche un suo sottogruppo, SLn(𝕂), detto gruppo lineare speciale (special linear group), formato dalle matrici con determinante uguale a 1.

La sottrazione è definita come somma con l’opposto di un elemento in (ℤ,+).

a − b : = a + (−b) = a + b−1

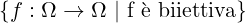

S(Ω) =  è chiamato gruppo simmetrico (symmetric

group) (struttura algebrica) dell’insieme Ω.

è chiamato gruppo simmetrico (symmetric

group) (struttura algebrica) dell’insieme Ω.

È un gruppo rispetto alla composizione di funzioni.

Contiene tutte le possibili permutazioni degli elementi di Ω.

Tutti i gruppi simmetrici di insiemi aventi la stessa cardinalità sono isomorfi

(isomorphic).

L’elemento neutro è la funzione identità id (id(x) : = x).

Se Ω è finito, il suo gruppo simmetrico si denota con Sn.

In genere in questi casi si preferisce considerare il gruppo delle permutazioni degli

interi 1...n dato che è isomorfo.

Se (A,∗) è un magma si dice che ∗è commutativa se scambiando l’ordine degli

operandi il risultato non cambia.

In simboli:

∀a,b ∈ A.a ∗ b = b ∗ a.

Un gruppo (A,∗) è detto abeliano (abelian) (struttura algebrica) o commutativo (commutative) se ∗è commutativa.

Se (A,∗) e (A,+) sono magmi, si dice che ∗è distributiva rispetto a + se è

distributiva a destra e a sinistra rispetto a +.

Se ∗è commutativa, distributività, distributività a destra e distributività a sinistra sono equivalenti.

Una operazione binaria esterna ∗ : A × B → B si dice distributiva a

destra rispetto all’operazione + : B × B → B di un magma (A,+) se:

∀a ∈ A,b,c ∈ B.a ∗ (b + c) = (a ∗ b) + (a ∗ c)

Una operazione binaria ∗ : A × C → A si dice distributiva a sinistra rispetto

all’operazione + : A × A → A di un magma (A, +) se:

∀a,b ∈ A,c ∈ C.(a + b) ∗ c = (a ∗ c) + (b ∗ c)

Un insieme A dotato di due operazioni binarie interne  e

e  è un anello

(rng/non-unital ring) (struttura algebrica) (A,

è un anello

(rng/non-unital ring) (struttura algebrica) (A, ,

, ) se:

) se:

(A, ) è un gruppo abeliano.

) è un gruppo abeliano.

(A, ) è un semigruppo.

) è un semigruppo.

è distributiva rispetto a

è distributiva rispetto a  .

.

Un anello (A, ,

, ) è un anello unitario (ring) (o con unità) (struttura

algebrica) se (A,

) è un anello unitario (ring) (o con unità) (struttura

algebrica) se (A, ) è anche un monoide (

) è anche un monoide ( ammette elemento neutro).

ammette elemento neutro).

Se  è commutativa l’anello si dice commutativo (commutative) (struttura

algebrica).

è commutativa l’anello si dice commutativo (commutative) (struttura

algebrica).

Se (A, ,

, ) è un anello e (A∗,

) è un anello e (A∗, ) è un gruppo, dove A∗: = A∖

) è un gruppo, dove A∗: = A∖ e 0 è l’elemento

neutro di

e 0 è l’elemento

neutro di  , allora (A,

, allora (A, ,

, ) è anche un corpo (division ring) (struttura

algebrica).

) è anche un corpo (division ring) (struttura

algebrica).

Un campo (field) (o corpo commutativo) (𝕂,+,⋅) è un anello unitario

commutativo, con 0 elemento neutro di + e 1 elemento neutro di ⋅, in

cui 0≠1 e (𝕂∗,⋅) è un gruppo abeliano, dove 𝕂∗ : = 𝕂 ∖ (aggiunge

il requisito di invertibilità di ogni elemento ≠0 per la moltiplicazione).

(aggiunge

il requisito di invertibilità di ogni elemento ≠0 per la moltiplicazione).

Alternativamente:

(𝕂,+) è un gruppo abeliano con elemento neutro 0

𝕂∗: = 𝕂 ∖

(𝕂∗,⋅) è un gruppo abeliano con elemento neutro 1

⋅è distributiva rispetto a +.

(𝔽, ,∧), 𝔽 : =

,∧), 𝔽 : =  ,

, : = XOR, ∧: = AND

: = XOR, ∧: = AND

(ℚ,+,⋅)

(ℝ,+,⋅)

(ℂ,+,⋅)

(V,⊕,∗) è detto spazio vettoriale (vector space) (struttura algebrica) su di un

campo (𝕂,+,⋅) se:

(V,⊕) è un gruppo abeliano (⊕è detta somma (di vettori) o legge di

composizione interna)

V è dotato di una operazione binaria esterna ∗ : 𝕂 ×V → V (detta prodotto per

scalare (gli elementi di 𝕂 sono detti scalari) o legge di composizione esterna)

∗è pseudo-associativa (o compatibile con la moltiplicazione nel campo):

∀a,b ∈ 𝕂,v ∈ V.(a ⋅ b) ∗v = a ∗ (b ∗v )

∗ ammette elemento neutro sinistro ∈ 𝕂 (unitarietà)

∗è distributiva a destra rispetto a ⊕

∗è pseudo-distributiva a sinistra rispetto a + (o compatibile con l’addizione nel

campo, insieme alla precedente pseudo-distributività):

∀a,b ∈ 𝕂,v ∈ V.(a + b) ∗v = (a ∗v ) ⊕ (b ∗v )

Curiosità:

Le ultime quattro proprietà (assiomi) dicono che il prodotto per scalare definisce

un omomorfismo (trasformazione che preserva la struttura algebrica)

(homomorphism, structure preserving map) tra l’anello del campo 𝕂 ((𝕂,+,⋅)) e

l’anello degli endomorfismi (endomorphism ring) (morfismi da un oggetto a se

stesso) del gruppo (V,⊕).

Notazione:

V (𝕂)

L’elemento neutro della somma di vettori, il vettore nullo, è scritto 0.

Un campo (𝕂,+,⋅) è spazio vettoriale su se stesso con:

∗: = ⋅

⊕: = +

𝕂n è dotato di struttura di spazio vettoriale su 𝕂 rispetto a ⊕ e ∗ definiti

componente per componente. (𝕂n,⊕) è gruppo abeliano.

Tutti gli spazi vettoriali di dimensione uguale sono isomorfi.

Gli elementi di V sono vettori geometrici, cioè freccie orientate.

La somma di vettori è definita con la regola del parallelogramma.

Ogni vettore ammette inverso.

Il prodotto per scalare è un vettore con la stessa direzione di quello originale

ma con lunghezza moltiplicata per lo scalare e verso in base al segno.

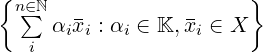

V (𝕂) spazio vettoriale, v 1...v n ∈ V

Si dice cominazione lineare dei vettori v 1...v n (necessariamente in numero

finito) mediante gli scalari α1...αn il vettore:

v = α1v 1 + α2v 2 + ... + αnv n = ∑ in∈ℕαiv i

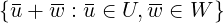

S ⊆ V è sottospazio vettoriale (linear subspace) (struttura algebrica) di V (𝕂)

se:

S è dotato dell’operazione binaria interna di somma di (V,+) ristretta ad S ×S e

troncata ad S (Im(+S×S) ⊆ S)

S è dotato dell’operazione binaria interna di prodotto per scalare di V (𝕂)

ristretta a 𝕂 × S e troncata ad S (Im(∗𝕂×S) ⊆ S)

(S,+|S×SS,∗|𝕂×SS) è uno spazio vettoriale su 𝕂

Se S ⊆ V gli assiomi degli spazi vettoriali sono già verificati (devono valere per

tutti gli elementi in V).

Dunque ciò a cui va fatta attenzione sono la presenza del vettore nullo (0) in S e

le proprietà di chiusura della somma di vettori e del prodotto per scalare.

Notazione:

S ≤ V (𝕂) si legge come S è sottospazio vettoriale di V (𝕂)

Se V (𝕂) è spazio vettoriale con operazioni + e ∗, per determinare se S ⊆ V è

sottospazio vettoriale di V si può usare il seguente albero decisionale:

Le operazioni + e ∗ di S sono diverse da quelle di V ? → Non è sottospazio

0 (vettore nullo) ⁄∈ S? → Non è sottospazio

¬(∀α ∈ 𝕂,v ∈ S.α ∗v ∈ S) → Non è sottospazio

¬(∀u ,v ∈ S.u + v ∈ S) → Non è sottospazio

È sottospazio

S è sottospazio vettoriale di V (𝕂) ⇐⇒ S è chiuso rispetto alle combinazioni

lineari

Ovvero:

∀α,β ∈ 𝕂,v ,w ∈ S.αv + βw ∈ S

Se V (𝕂) è uno spazio vettoriale, e X ⊆ V (𝕂) un insieme/sequenza/sistema di

vettori di V (𝕂), si dice che V (𝕂) è generato da X se ogni vettore di V (𝕂) si

può scrivere come combinazione lineare di un numero finito di elementi di X. X

si dice insieme di generatori per V (𝕂).

Alternativamente:

X è insieme di generatori per V (𝕂) ⇐⇒ℒ(X) = V .

Uno spazio vettoriale è insieme di generatori per se stesso.

Aggiungere vettori ad un insieme di generatori fornisce ancora un insieme di

generatori.

V (𝕂) è detto finitamente generato se ∃X ⊆ V (𝕂) con  < ∞ e X insieme

di generatori per V (𝕂).

< ∞ e X insieme

di generatori per V (𝕂).

Siano V (𝕂) uno spazio vettoriale e X ⊆ V (𝕂).

ℒ(X), detta copertura lineare (linear span) (o chiusura lineare) di X, è

l’insieme di tutte le combinazioni lineari dei vettori in X.

In simboli:

ℒV (𝕂)(X) = ℒ(X) =  : =

: =

ℒ(∅) : =

ℒ(X) è sempre un sottospazio vettoriale di V (𝕂).

Inoltre, è il più piccolo sottospazio vettoriale di V (𝕂) che contiene X.

A ⊆ B  ℒ(A) ⊆ℒ(B)

ℒ(A) ⊆ℒ(B)

A = ℒ(A) ⇐⇒ A è sottospazio vettoriale.

ℒ(ℒ(A)) = ℒ(A)

Siano V (𝕂) uno spazio vettoriale ed S = (v 1,...,v n) una sequenza di suoi vettori.

S è detta libera se l’unica combinazione lineare dei suoi elementi che da 0

è quella a coefficienti tutti nulli. I vettori di S si dicono linearmente

indipendenti (linearly independent).

S è detta legata se esiste almeno una combinazione lineare dei suoi elementi a

coefficienti non tutti nulli che da 0. I vettori di S si dicono linearmente

dipendenti (linearly dependent).

S è legata = S non è libera.

0 ∈ S  S è legata.

S è legata.

v1 ∈ S ∧∃α≠0 : v 2 = αv 1 ∈ S  S è legata (quindi anche se ci sono due vettori

uguali, con α = 1).

S è legata (quindi anche se ci sono due vettori

uguali, con α = 1).

X è libera ∧ Y ⊆ X  Y è libera.

Y è libera.

X è legata ∧ X ⊆ Y  Y è legata.

Y è legata.

∃v ≠0 ∈ S  ∃X ⊆ S : X è libera

∃X ⊆ S : X è libera

S è legata ⇐⇒ almeno uno dei suoi vettori si può scrivere come combinazione lineare dei rimanenti.

Si dice base (ordinata) (ordered basis) di uno spazio vettoriale ogni sua sequenza

di generatori libera.

Osservazione:

V (𝕂)≠

V (𝕂) ammette basi

V (𝕂) ammette basi

(Non esistono in V (𝕂) vettori linearmente indipendenti  V (𝕂) è uno spazio

vettoriale banale.

V (𝕂) è uno spazio

vettoriale banale.

Ogni spazio vettoriale finitamente generato non banale ammette base)

B = (b 1,...,b n) è una base ordinata per V (𝕂) ⇐⇒ ogni vettore di V (𝕂) si scrive in modo unico come combinazione lineare degli elementi di B.

Si dicono componenti (components) di un vettore v ∈ V n(𝕂) rispetto ad una base B di V n(𝕂) gli elementi della ennupla dei coefficienti che danno la combinazione lineare dei vettori di B che fornisce v .

La base di uno spazio vettoriale composta da vettori i cui componenti sono tutti 0 eccetto uno, che è 1, è detta base canonica (standard/canonical basis).

Il Lemma di Steinitz formalizza la nozione che la lunghezza di una sequenza di

generatori ≥ la lunghezza di una sequenza libera in uno spazio vettoriale.

Conseguenze:

Ogni base di V (𝕂) ha il medesimo numero di elementi.

Ogni sequenza di vettori in V (𝕂) con numero di elementi maggiore di quello di

una base di V (𝕂) è legata.

Ogni sequenza di generatori di V (𝕂) con lo stesso numero di elementi di una base

di V (𝕂) è libera, e dunque base.

Ogni sequenza libera di V (𝕂) con lo stesso numero di elementi di una base di

V (𝕂) genera lo spazio, e dunque è base.

Nessuna sequenza con meno vettori di una base di V (𝕂) genera lo spazio.

Per il lemma di Steinitz ogni base di uno spazio vettoriale V (𝕂) ha il medesimo

numero di elementi.

Questo numero è detto dimensione (dimension) di V (𝕂).

Una funzione f : V (𝕂) → W(𝕂) è detta trasformazione/applicazione/mappa

lineare (o omomorfismo di spazi vettoriali) (linear transformation/map o vector

space homomorphism) se associa combinazioni lineari in uno spazio vettoriale

V (𝕂) a combinazioni lineari in un altro spazio vettoriale W(𝕂). In altre

parole conserva le operazioni di somma di vettori e prodotto per scalare.

In simboli:

∀v ,u ∈ V,α,β ∈ 𝕂.f(αv + βu ) = αf(v ) + βf(u )

Una trasformazione lineare è un morfismo (categorico) (trasformazione che preserva la struttura algebrica, generalizzazione di omomorfismo) (morphism (CT)) (structure preserving map).

Una trasformazione lineare è detta isomorfismo (lineare) ((linear) isomorphism)

⇐⇒ è invertibile.

La funzione che associa ad ogni vettore di uno spazio vettoriale la ennupla dei

suoi componenti rispetto ad una base B è un isomorfismo.

In simboli:

fB : V (𝕂) → 𝕂n

fB(v = α1e 1 + ... + αne n) = (α1,...,αn)

V (𝕂) 𝕂n

𝕂n

Uno spazio vettoriale è quindi univocamente descritto dal campo 𝕂 su cui è

definito e da un numero n pari alla sua dimensione (uguale al numero di elementi

di tutte le sue basi, vedi definizione di dimensione), dato che è isomorfo a 𝕂n.

Tutti gli spazi vettoriali di uguale dimensione sul medesimo campo sono isomorfi (cioè esiste un isomorfismo tra di loro (e viceversa se esiste un isomorfismo hanno la stessa dimensione)).

Si dice endomorfismo di V n(𝕂) una trasformazione lineare f : V n(𝕂) → V n(𝕂)

Sono rappresentati da matrici quadrate (e viceversa).

In generale si può considerare f ∘ g e g ∘ f dato che hanno lo stesso dominio e

codominio.

Se f è rappresentato dalla matrice A e g è rappresentato dalla matrice B, f ∘g è rappresentato dalla matrice AB

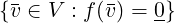

Si dice nucleo (kernel) di una trasformazione lineare la controimmagine del

vettore nullo tramite f.

In simboli:

kerf =

Osservazioni:

kerf ≤ V (𝕂)

f è iniettiva ⇐⇒ kerf =

Una trasformazione lineare manda sequenze libere in sequenze libere ⇐⇒ il suo

nucleo è banale ( ) (cioè è iniettiva).

) (cioè è iniettiva).

(nullity)

Null(f) : = dim(ker(f))

U(𝕂),W(𝕂) ≤ V (𝕂)

U ∩ W è un sottospazio vettoriale di V (𝕂)

Osservazione:

U,W ≤ V (𝕂)  0 ∈ U ∩ W

0 ∈ U ∩ W

Due sottospazi di V (𝕂) non possono mai essere disgiunti! (cioè U ∩ W≠0).

W ≤ V  dim(W) ≤ dim(V )

dim(W) ≤ dim(V )

dim(W) = dim(V ) ⇐⇒ W = V

0 ≤ dim(U ∩ W) ≤ min(dim(U),dim(W))

Si dimostrano le proprietà di chiusura.

∀0 ≤ i ≤ n.∃W ≤ V n(𝕂) : dim(W) = i

U(𝕂),W(𝕂) ≤ V (𝕂)

U ∪ W ≤ V (𝕂) ⇐⇒ U ⊆ W ∨ W ⊆ U

U(𝕂),W(𝕂) ≤ V (𝕂)

U ∪ W in generale non è un sottospazio di V (𝕂).

Per questo motivo viene introdotta la nozione di somma di spazi vettoriali.

U + W =

U + W = ℒ(U ∩ W)

Cioè U + W è il più piccolo sottospazio di V (𝕂) che contiene U e W.

U,W ≤ U + W ≤ V n(𝕂)

max(dim(U),dim(W)) ≤ dim(U + W) ≤ V n(𝕂)

U(𝕂),W(𝕂) ≤ V (𝕂)

La somma U + W si dice diretta (direct sum) e si scrive U ⊕W se ogni elemento

di U + W si scrive in modo unico come somma di un elemento di U ed un

elemento di W.

In simboli:

∀x ∈ U + W.∃!u ∈ U,w ∈ W : x = u + w

U ⊕ W ⇐⇒ U ∩ W =

Conseguenze:

BU una base di U e BW una base di W.

BU ∪ BW è una base di U ⊕ W

dim(U ⊕ W) = dim(U) + dim(W)

dim(U + W) = dim(U) + dim(W) − dim(U ∩ W)

Analogia con la formula per la cardinalità dell’unione di due insiemi, che usa

anch’essa il principio di inclusione ed esclusione:

Siano X,Y insiemi.

=

=  +

+  −

−

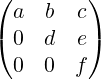

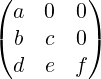

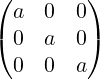

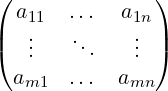

Matrice (matrix) m × n (righe × colonne) a coefficienti in 𝕂:

Matm,n(𝕂) = 𝕂m,n = 𝕂m,n

Elementi (entries) ai,j

m≠n → matrice rettangolare

m = n → matrice quadrata

A ∈ Matm,n(𝕂)

∖ = diagonale principale

∕ = diagonale secondaria

ai,j = 0 ∀i > j

ai,j = 0 ∀j > i

ai,j = 0 ∀i > j

con ai,i = k ∈ 𝕂

ai,i = 1

In

I3 =

ai,j = 0 ∀i,j

A ∈ Matm,n(𝕂)

Matrice trasposta di A:

AT

Righe e colonne scambiate.

ai,j = aj,i

A = (AT )T

A = AT  A è simmetrica, A è quadrata

A è simmetrica, A è quadrata

Somma elemento per elemento (per matrici di dimensioni uguali)

(Matm,n(𝕂),+) è un gruppo abeliano.

Distributivo rispetto all’addizione

Non commutativo

Associativo

Distributivo rispetto alla somma

A ⋅ B = 0 A = 0 ∨ B = 0

A = 0 ∨ B = 0

(A ⋅ B)T = BT ⋅ AT

Se:

A ⋅ X = B

dato che la divisione tra matrici non è definita, non si scrive:

X = B∕A

X =

ma:

X = A−1 ⋅ B

Solo per matrici quadrate.

det(A)

Differenza prodotto diagonali

Differenza (somme prodotti diagonali e prodotti sovradiagonali).

Se A è triangolare superiore il determinante è il prodotto della diagonale

A ∈ Matn(𝕂), n ≥ 2

= ∑

j=1n(−1)i+jai,j ⋅

= ∑

j=1n(−1)i+jai,j ⋅

Dove Ai,j è la matrice ottenuta da A togliendo ad A la i-esima riga e la j-esima

colonna.

Il valore (−1)i+j è detto complemento algebrico di ai,j.

è detto complemento algebrico di ai,j.

Osservazione:

Il termine (−1)i+j indica che se la somma degli indici di riga e colonna è dispari,

il segno nella somma va cambiato, altrimenti va mantenuto.

Osservazione:

Si può applicare Laplace per righe / colonne qualsiasi, ma per snellire i conti

conviene scegliere righe / colonne con il maggior n° di 0.

= 1

= 1

= ∏

i=1nai,i

= ∏

i=1nai,i

Quando A è triangolare / diagonale (anche rispetto alla diagonale secondaria,

anche se in quel caso non si chiama triangolare / diagonale)

=

=

=

=  ⋅

⋅

Osservazione:

In generale non vale per la somma.

Se in A c’è una riga / colonna nulla, allora  = 0

= 0

Scambiando righe e colonne il determinante cambia di segno.

Se una riga / colonna è combinazione lineare di altre righe / colonne, allora

= 0 e viceversa.

= 0 e viceversa.

Quando una riga / colonna si può scrivere utilizzando le altre righe / colonne

combinate solo con operazioni di somma / prodotto e/o prodotto per scalare.

Osservazione:

Se una riga / colonna è multipla di un’altra riga / colonna allora è una sua

combinazione lineare.

Sommando a una riga / colonna una combinazione lineare delle altre righe /

colonne il determinante non cambia.

Una matrice quadrata si dice non singolare se il suo deteminante è ≠0. Altrimenti si dice singolare (singular / degenerate).

Si dice inversa di A, se ∃, la matrice A−1 tale che:

A ⋅ A−1 = A−1 ⋅ A = In

(Ovvero A−1 è inversa destra e sinistra di A)

Osservazione:

Sia A ∈ Matn(𝕂), ∃A−1 ⇐⇒ ≠0

≠0

Cioè A ammette inversa se e solo se A è non singolare.

In altre parole A ammette inversa ⇐⇒ det(A) ammette inverso moltiplicativo, dato che det(A) ⋅ det(A−1) = 1

Data A = (ai,j) ∈ Matn(𝕂) si dice matrice dei complementi algebrici o

matrice dei cofattori (cofactor matrix) di A la matrice cof A ∈ Matn(𝕂) ottenuta

sostituendo in A ogni elemento col suo complemento algebrico o cofattore

(cofactor) (c).

cof i,j(A) = ci,j = (−1)i+j

La trasposta della matrice dei cofattori di A è detta matrice aggiunta adjA o

Aa o Aa (adjugate matrix / classical adjoint of a square matrix / adjunct matrix

/ “adjoint”)

adjA = (cof A)T

≠0

≠0  A−1 =

A−1 =  ⋅ adjA

⋅ adjA

Data una matrice A ∈ Matm,n(𝕂) si dice minore di ordine p una matrice quadrata di ordine p ottenuta da A sopprimendo n − p colonne e m − p righe.

Data una matrice A ∈ Matm,n(𝕂) dire che il rango (rank) di A è p:

rg(A) = p

r(A) = p

ρ(A) = p

con p ≤ min(m,n)

significa dire che A ha un minore non singolare di ordine p, e che ogni eventuale

minore di ordine p + 1 è singolare.

r(A) = 0 ⇐⇒ A = 0

Se A ∈ Matn(𝕂) allora r(A) = n ⇐⇒ ≠0

≠0

A ha rango massimo = A ∈ Matn(𝕂), r(A) = n

1 ≤ rg(A) ≤ min(m,n), A ∈ Matm,n(𝕂), A≠0

A ∈ Matm,n(𝕂).

Il rango di A è p ⇐⇒∃ in A un minore di ordine p (Mp) non singolare ∧ ogni

minore di ordine p + 1 che contiene completamente Mp è singolare.

Che ha al suo interno.

Siano V n(𝕂) e Wm(𝕂) due spazi vettoriali e:

B = (e 1,...,e n) base di V n(𝕂)

B′ = (e ′1,...,e ′m) base di Wm(𝕂)

Osservazione:

I valori di una trasformazione lineare f : V (𝕂) → W(𝕂) dipendono solamente dai

valori di f sui vettori di una base di V (𝕂), perché:

∀v ∈ V n(𝕂).v = α1e 1 + ... + αne n

∀v ∈ V n(𝕂).f(v ) = f(α1e 1 + ... + αne n) = α1f(e 1) + ... + αnf(e n)

Quindi f è definita dai valori:

f(e 1) = w 1

f(e n) = w n

con w 1...w n ∈ W.

w1...w n sono tutti combinazione lineare di vettori della base B′ di W

In simboli:

∀j ∈ ℕ,1 ≤ j ≤ n.w j = ∑

i=1maije ′i

con aij ∈ 𝕂

Quindi f : V n(𝕂) → Wm(𝕂) è descritta interamente da una matrice m×n degli

scalari aij e dalle basi del dominio e del codominio scelte.

Inoltre, rappresentando le ennuple dei componenti dei vettori di V (𝕂) rispetto

alla base B come matrici (vettori colonna), ad esempio:

e 1 =

e moltiplicando la matrice corrispondente ad una trasformazione lineare per la

matrice corrispondente ad un vettore, si ottiene il valore della trasformazione

lineare applicata al vettore come vettore colonna di componenti rispetto alla base

B′ di W(𝕂) , ad esempio:

=

=

Le matrici rappresentano funzioni tra spazi vettoriali, e sono a loro volta uno

spazio vettoriale.

Il prodotto di matrici corrisponde alla composizione di funzioni (lineari).

Rk(f) : = dim(Im(f))

Osservazione:

Se f : 𝕂n → 𝕂m allora Im(f) è generata dalle colonne della matrice che

rappresenta f

rk(f) = dimensione dello spazio vettoriale generato dalle colonne di f

(rank-nullity theorem)

f : 𝕂n → 𝕂m lineare

Null(f) + Rk(f) = n

(dimensione nucleo + dimensione immagine = dimensione dominio)

È utile poter determinare se una trasformazione lineare è un isomorfismo, cioè è

biiettiva.

Affinché una trasformazione lineare sia un isomorfismo deve essere invertibile.

Dunque deve esistere la matrice inversa di una qualsiasi matrice associata alla

trasformazione lineare, cioè quest’ultima deve essere invertibile.

Determinare se una matrice quadarata è invertibile equivale a determinare se le

sue colonne sono linearmente indipendenti, e questo porta alla definizione di

determinante.

Il determinante della matrice associata caratterizza anche il fattore per cui le aree / i volumi sono scalati dalla trasformazione lineare. Da questo punto di vista quando il determinante è nullo lo spazio viene ridotto ad una dimensione inferiore, e quindi le aree diventano 0. Essendoci perdita di informazione la trasformazione lineare non può essere un isomorfismo.

Serve una funzione:

det : 𝕂n,n → 𝕂

tale che det(A) = 0 ⇐⇒ le colonne di A sono linearmente indipendenti

e che sia facile da calcolare.

det(In) : = 1

det(c1...cn) : = 0 se ci sono due colonne uguali.

Imponiamo infine il determinante lineare in ogni singola colonna.